Nvidia meluncurkan teknologi percakapan AI untuk Bot yang lebih cerdas

Catatan: Dalam topik berikutnya yang akan Anda baca, Anda akan mempelajari tentang: Nvidia meluncurkan teknologi percakapan AI untuk Bot yang lebih cerdas

Situs ini dapat memperoleh komisi afiliasi dari tautan di situs ini. Syarat Penggunaan.

Sekarang, untuk hampir semua perangkat dan ponsel yang mungkin telah mereka adopsi atau setidaknya menguji kontrol suara, percakapan AI dengan cepat menjadi batas baru. Alih-alih memproses satu permintaan dan memberikan tanggapan atau tindakan, AI Percakapan bertujuan untuk menyediakan sistem Interaktif waktu nyata yang dapat mencapai banyak pertanyaan, jawaban, dan komentar. Meskipun komponen inti percakapan AI, seperti BERT dan RoBERTa untuk pemodelan bahasa, serupa dengan komponen untuk pengenalan ucapan tunggal, konsep ini dilengkapi dengan persyaratan kinerja, kapasitas tambahan untuk pelatihan, inferensi, dan ukuran model. Hari ini, Nvidia merilis tiga teknologi sumber terbuka yang dirancang untuk mengatasi masalah tersebut.

Pelatihan BERT lebih cepat

Meskipun dalam banyak kasus dimungkinkan untuk menggunakan model bahasa pra-terlatih untuk tugas-tugas baru saja, untuk kinerja optimal dalam konteks tertentu, penting untuk melatih kembali. Nvidia telah menunjukkan bahwa Anda sekarang dapat melatih BERT (Model Bahasa Referensi Google) dalam waktu kurang dari satu jam di DGX SuperPOD, yang mencakup 1.472 GPU Tesla V100-SXM3-32GB, 92 server DGX-2H, dan 10 Mellanox Infiniband per node. Tidak, saya bahkan tidak menginginkan perkiraan sewa per jam untuk salah satunya. Tetapi karena model seperti ini sering membutuhkan waktu berhari-hari untuk dilatih bahkan pada kelompok GPU kelas atas, ini pasti akan membantu mengkomersialkan perusahaan yang mampu membelinya.

Meskipun dalam banyak kasus dimungkinkan untuk menggunakan model bahasa pra-terlatih untuk tugas-tugas baru saja, untuk kinerja optimal dalam konteks tertentu, penting untuk melatih kembali. Nvidia telah menunjukkan bahwa Anda sekarang dapat melatih BERT (Model Bahasa Referensi Google) dalam waktu kurang dari satu jam di DGX SuperPOD, yang mencakup 1.472 GPU Tesla V100-SXM3-32GB, 92 server DGX-2H, dan 10 Mellanox Infiniband per node. Tidak, saya bahkan tidak menginginkan perkiraan sewa per jam untuk salah satunya. Tetapi karena model seperti ini sering membutuhkan waktu berhari-hari untuk dilatih bahkan pada kelompok GPU kelas atas, ini pasti akan membantu mengkomersialkan perusahaan yang mampu membelinya.

Inferensi model bahasa lebih cepat

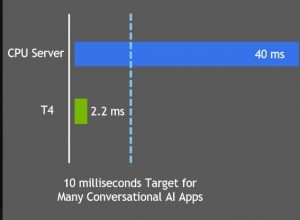

Untuk percakapan alami, tolok ukur industri adalah waktu respons 10 md. Memahami kueri dan memberikan jawaban yang disarankan hanyalah bagian dari proses, sehingga membutuhkan waktu kurang dari 10 md. Saat mengoptimalkan BERT menggunakan TensorRT 5.1, Nvidia menyelesaikannya dalam 2,2 md pada Nvidia T4. Hal baiknya adalah T4 benar-benar dapat dijangkau oleh sebagian besar proyek serius. Saya menggunakannya di Google Compute Cloud untuk sistem pembuatan teks saya. Server virtual 4-vCPU dengan T4 disewa dengan harga lebih dari $1/jam saat saya mengerjakan proyek.

Dukungan untuk model yang lebih besar

Salah satu keunggulan jaringan saraf Achilles adalah persyaratan bahwa semua parameter model (termasuk sejumlah besar bobot) ada dalam memori pada saat yang bersamaan. Itu membatasi kerumitan model yang dapat dilatih pada GPU berdasarkan ukuran RAM-nya. Dalam kasus saya, misalnya, desktop saya adalah Nvidia GTX 1080

Salah satu keunggulan jaringan saraf Achilles adalah persyaratan bahwa semua parameter model (termasuk sejumlah besar bobot) ada dalam memori pada saat yang bersamaan. Itu membatasi kerumitan model yang dapat dilatih pada GPU berdasarkan ukuran RAM-nya. Dalam kasus saya, misalnya, desktop saya adalah Nvidia GTX 1080 Anda hanya dapat melatih model yang sesuai dengan 8GB Anda. Saya dapat melatih model yang lebih besar di CPU saya, yang memiliki lebih banyak RAM, tetapi membutuhkan waktu lebih lama. Model bahasa GPT2 lengkap memiliki 1,5 miliar parameter, misalnya, dan versi yang diperluas memiliki 8,3 miliar

Anda hanya dapat melatih model yang sesuai dengan 8GB Anda. Saya dapat melatih model yang lebih besar di CPU saya, yang memiliki lebih banyak RAM, tetapi membutuhkan waktu lebih lama. Model bahasa GPT2 lengkap memiliki 1,5 miliar parameter, misalnya, dan versi yang diperluas memiliki 8,3 miliar

Namun, Nvidia telah menemukan cara untuk memungkinkan banyak GPU bekerja secara paralel dengan bahasa pemodelan. Seperti pengumuman lainnya hari ini, mereka telah membuka kode sumber untuk mewujudkannya. Saya ingin tahu apakah teknik ini khusus untuk model bahasa atau dapat diterapkan untuk memungkinkan pelatihan beberapa GPU untuk jenis jaringan saraf lainnya.

Seiring dengan pengembangan dan peluncuran kode ini di GitHub, Nvidia mengumumkan akan bekerja sama dengan Microsoft untuk meningkatkan hasil pencarian Bing, serta Clinc di agen suara, AI Passage di chatbots, dan RecordSure di platform lain untuk analisis percakapan.

Sekarang baca:

![Cara memperbaiki masalah streaming video Windows 10 [COMPLETE GUIDE] 3](http://applexgen.com/wp-content/uploads/2020/04/Como-solucionar-problemas-de-transmision-de-video-en-Windows-10.jpg)