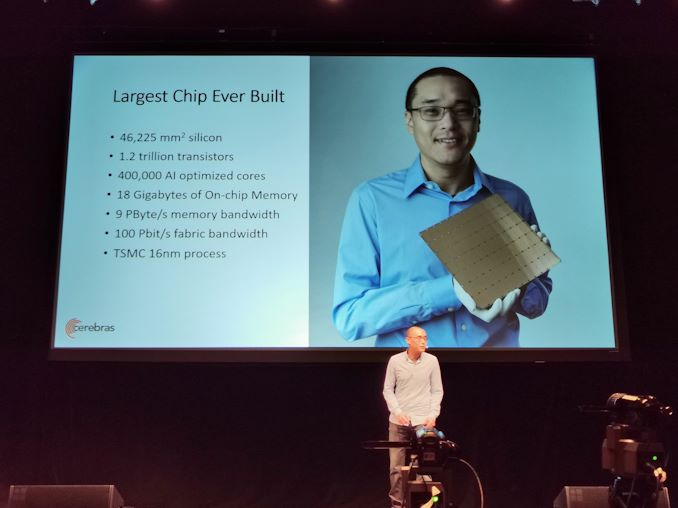

8:49 EDT – Några av de stora nyheterna idag är att Cerebras tillkännagav sin 1,2-biljoner rånstransistorlösning för djup inlärning. Dagens föredrag diskuterar detaljer om teknik.

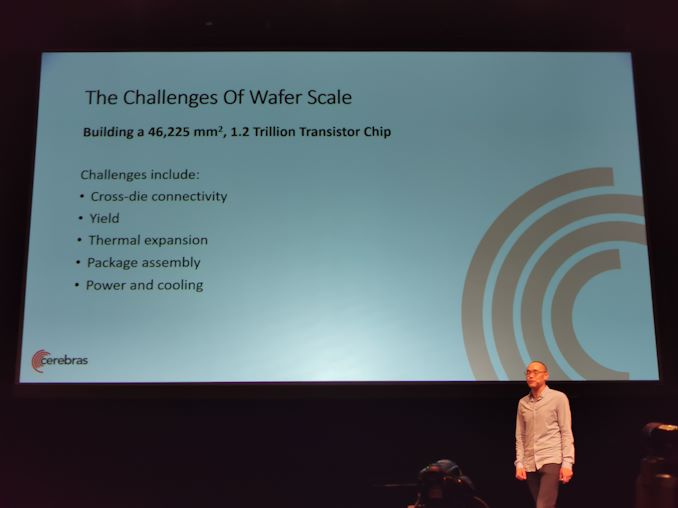

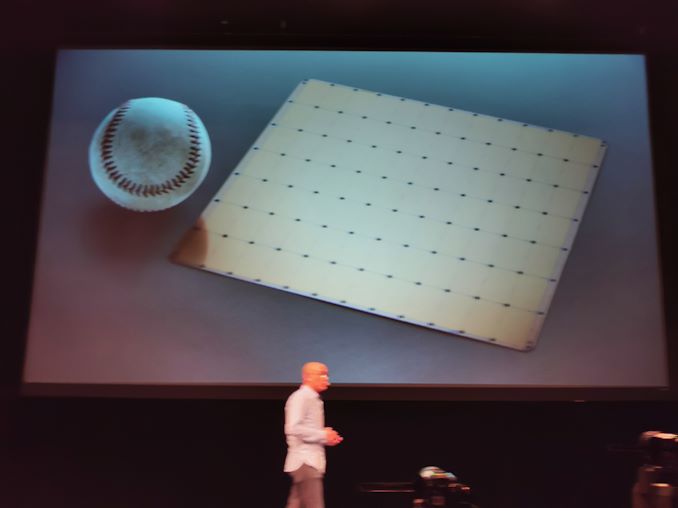

8:51 EDT – Spån med vågskala, mer än 46 225 mm2, 1,2 biljoner transistorer, 400 k AI-kärnor, matas med 18 GB SRAM-chip

8:51 EDT – 16nm TSMC

8:51 EDT – 215 mm x 215 mm – 8,5 tum per sida

8:51 EDT – 56 gånger större än den största GPU för tillfället

8:52 kl EDT – Byggt för Deep Learning

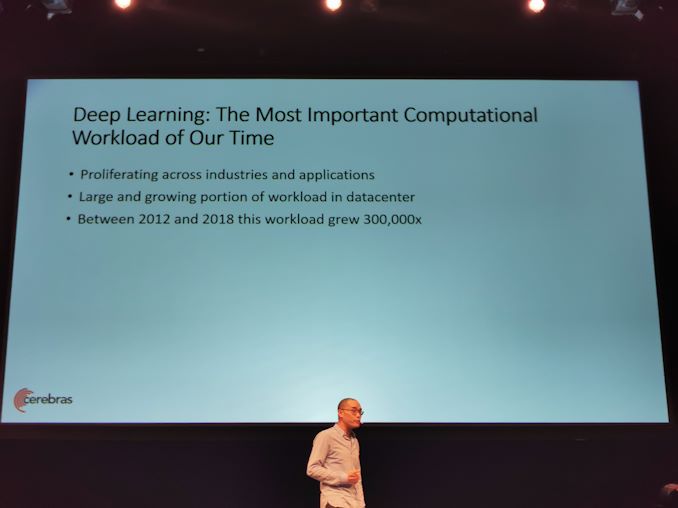

8:52 kl EDT – DL-träning är svårt (ed: detta är en underdrift)

8:52 kl EDT – Beräkningsområde för karta till exa skala

8:53 EDT – Problemets form är svår att mäta

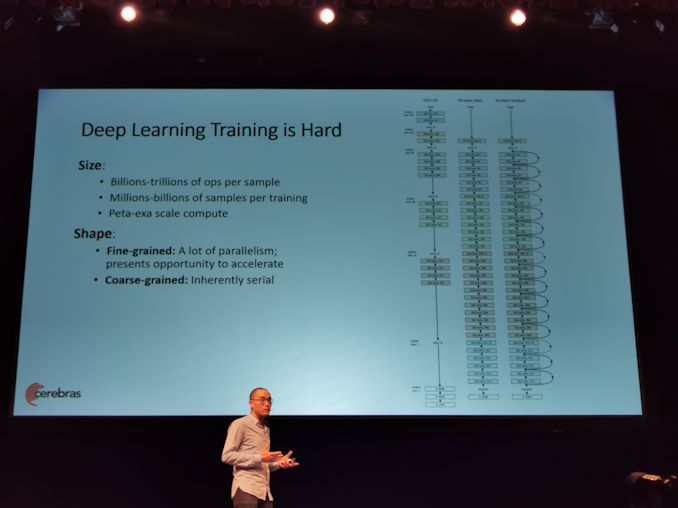

8:53 EDT – Fina korn har mycket parallellitet

8:53 EDT – Grova korn är i princip seriella

8:53 EDT – Utbildning är processen för att tillämpa små förändringar, seriellt

8:53 EDT – Problemets storlek och form gör NN-träningen mycket svår

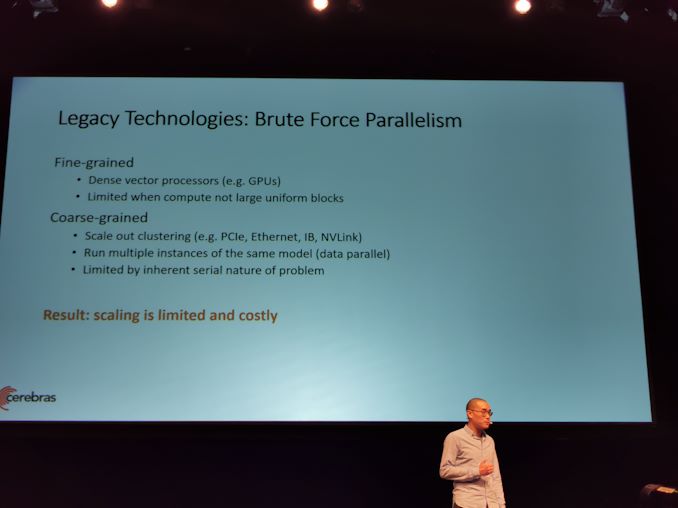

8:53 EDT – Idag har vi solid vektorgrafik

20:54 EDT – För grovt korn kräver höghastighets samtrafik för att köra mutliple-instanser. Fortfarande begränsad

20:54 EDT – Skalning är begränsad och dyr

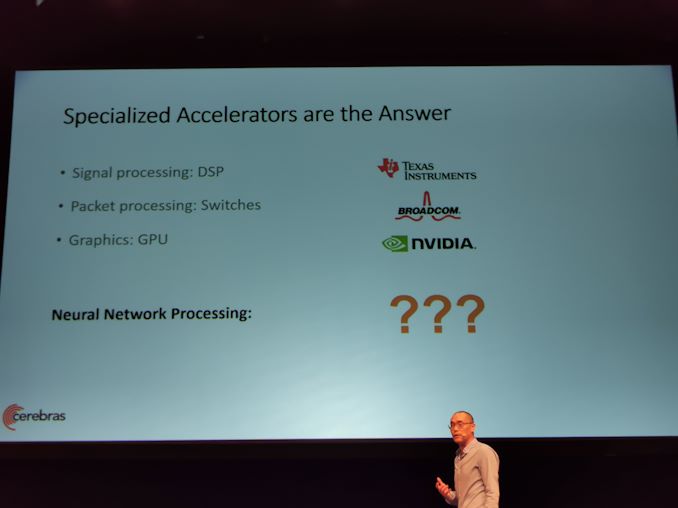

20:54 EDT – Speciella acceleratorer är svaret

08.55 EDT – NN: vad är rätt arkitektur

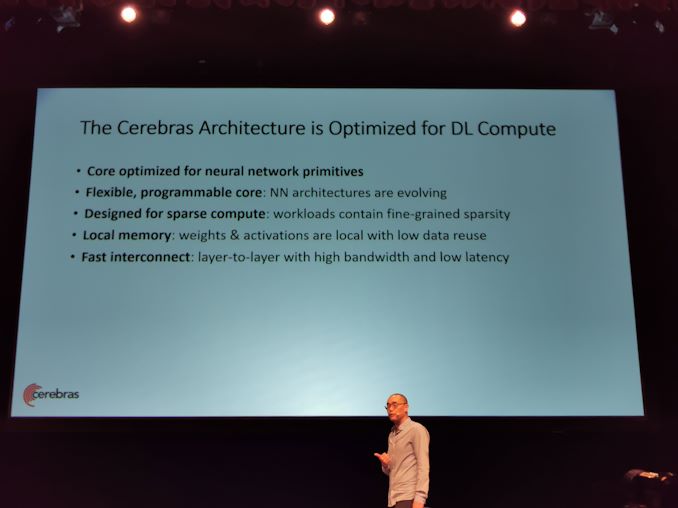

08.55 EDT – Behöver en kärna som ska optimeras för NN-primitiva

08.55 EDT – Behöver en programmerbar NN-kärna

08.55 EDT – Behöver göra snabb datoranvändning sällan

08.55 EDT – Kräver snabbt lokalt minne

08.55 EDT – Alla kärnor måste anslutas genom snabb samtrafik

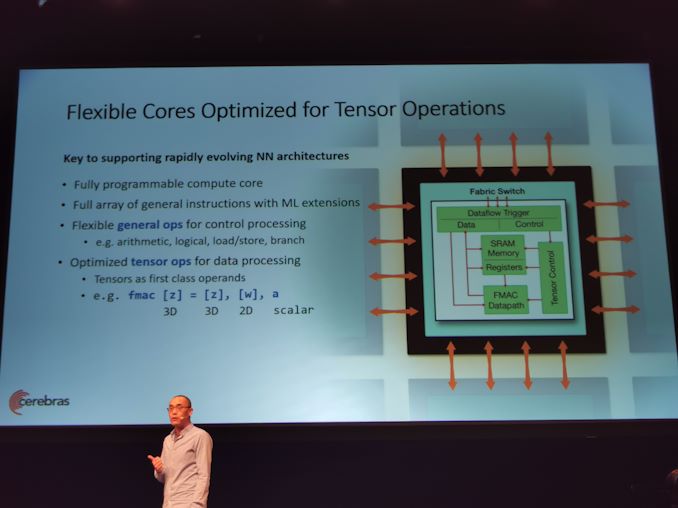

8:56 EDT – Cerebras använder en flexibel kärna. Flexibla allmänna operationer för kontrollbehandling

8:56 EDT – Kärnan måste hantera tensoråtgärder mycket effektivt

8:56 EDT – Form bulk för datoranvändning i alla neurala nätverk

8:56 EDT – Tensor som en första klassens pass

8:57 EDT – op fmac original

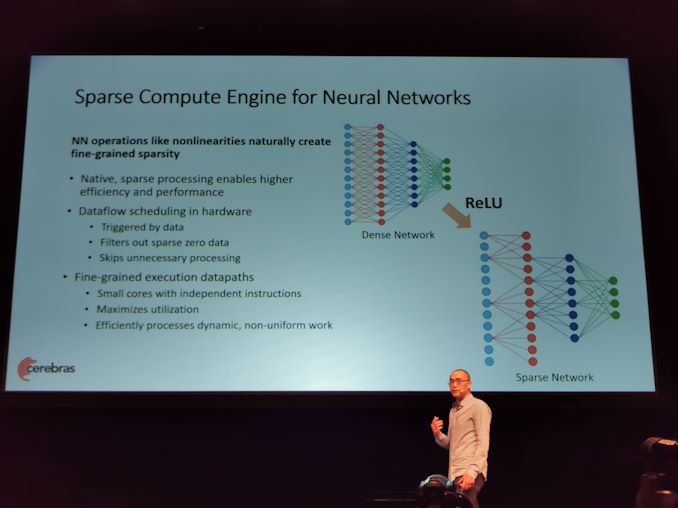

8:57 EDT – NN gör naturligtvis sällsynt vävnad

08:58 EDT – Core har naturlig, ovanlig bearbetning i hårdvara genom att schemalägga dataflöde

08:58 EDT – Alla beräkningar utlöses av data

08:58 EDT – Filtrera alla nollor sällan och filtrera jobb

08:58 EDT – Spara kraft och energi och få prestanda och acceleration genom att gå till nästa användbara jobb

08:58 EDT – Aktiveras eftersom arch har smidiga exekveringsdatapaths

08:58 EDT – Många små kärnor med oberoende instruktioner

8:59 EDT – Tillåter mycket icke-enhetligt arbete

8:59 EDT – Nästa är minne

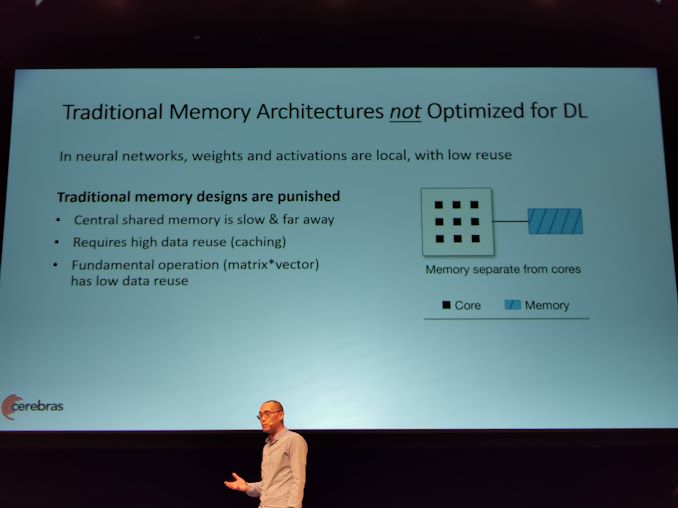

8:59 EDT – Traditionell minnesarkitektur är inte optimerad för DL

8:59 EDT – Traditionellt minne kräver hög datanvändning för prestanda

9:00 EDT – Multiplikation av normal matris har återanvändning av låg data

9:00 EDT – översätter Mat * Vec till Mat * Mat, men ändrar träningsdynamiken

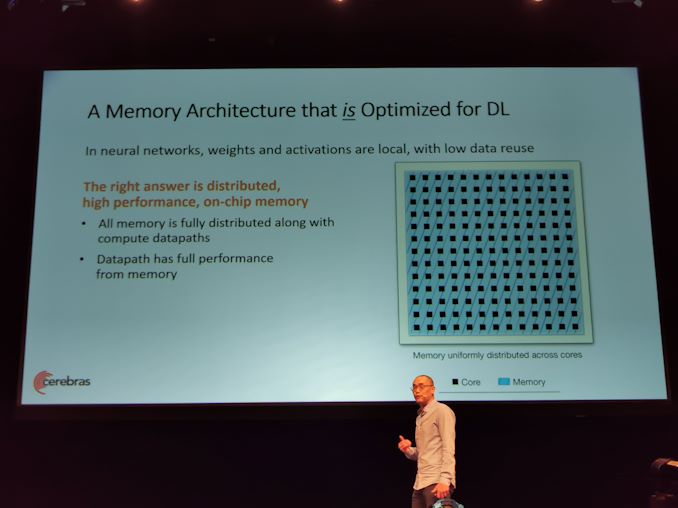

9:00 EDT – Cerebras har en mycket distribuerad och fullt distribuerad SRAM-chip bredvid kärnan

9:01 EDT – Få större bandbreddorder

9:01 EDT – ML kan göras på samma sätt som du vill göra det

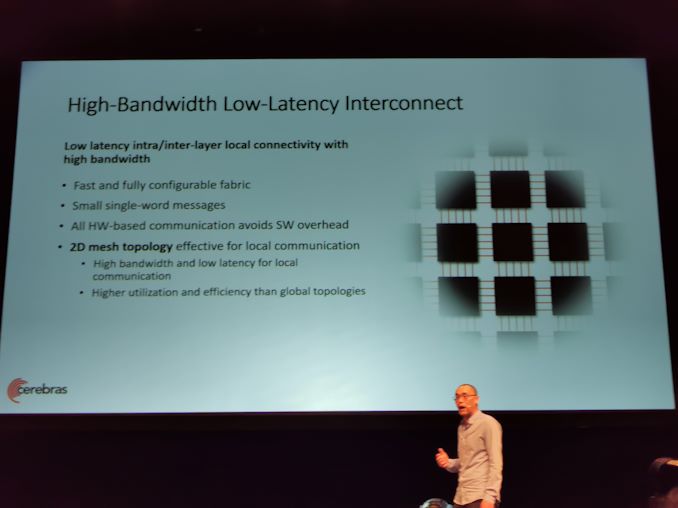

9:01 EDT – Hög bandbredd, samtrafik med låg latens

9:01 EDT – snabbt och helt konfigurerbart tyg

9:01 EDT – all hw-baserad kommunikation undviks över huvudet

21:02 EDT – 2D mesh topologi

21:02 EDT – Användning och effektivitet är högre än global topologi

21:02 EDT – Mer än en behöver dö

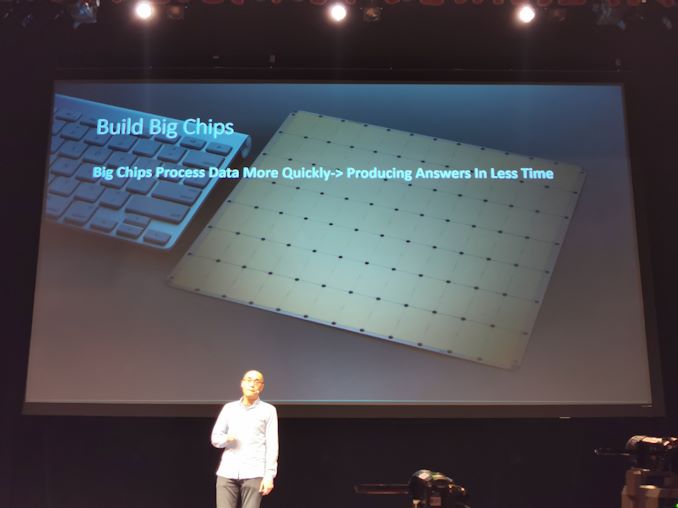

21:02 EDT – Solition är en skivskala

21:03 EDT – Bygg ett stort chip

21:03 EDT – Skala klusterskalan på ett chip

21:03 EDT – GB snabbminne (SRAM) 1 klockcykel från kärnan

21:03 EDT – Det är inte möjligt med off-chip-minne

21:03 EDT – Fullt sammankopplat tyg på chipet

21:03 EDT – Parallella modeller, skala linjär prestanda

21:04 EDT – Kartlägga hela nervnätverket till chipet på en gång

21:04 EDT – Ett exempel på NN, behöver inte öka batchstorleken för att få klusterskala perf

21:04 EDT – Mycket låg effekt och mindre utrymme

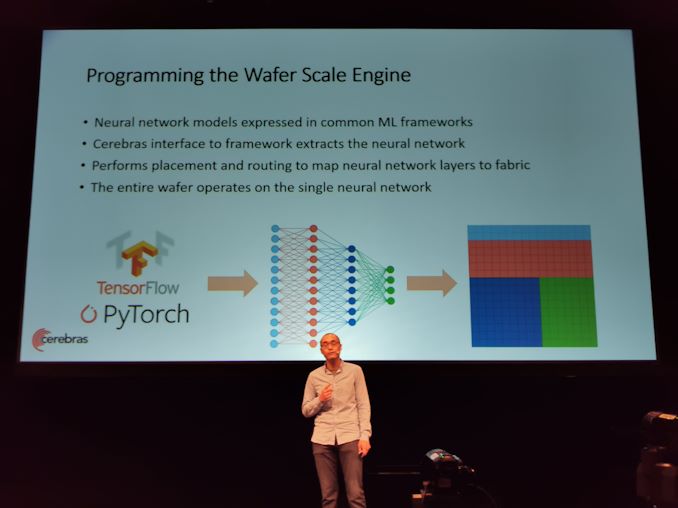

21:04 EDT – Kan använda TensorFlow och PyTorch

9:05 EDT – Utför placering och routing för att kartlägga neurala nätverkslager på tyget

9:05 EDT – Alla skivor fungerar på ett enda neuralt nätverk

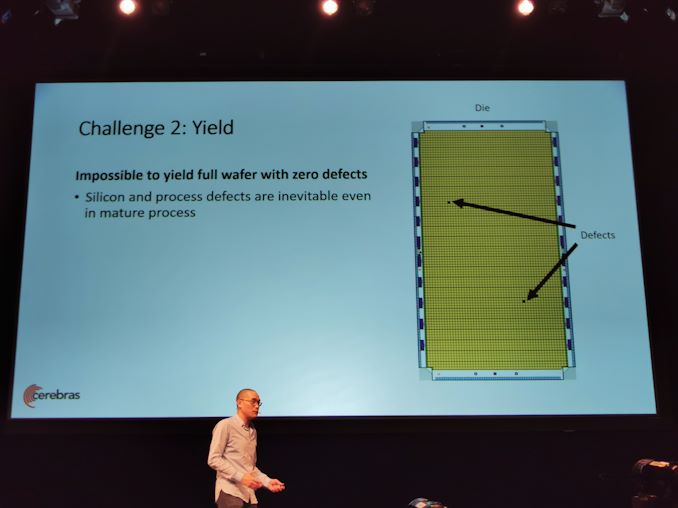

9:05 EDT – Utmaningar med skiva

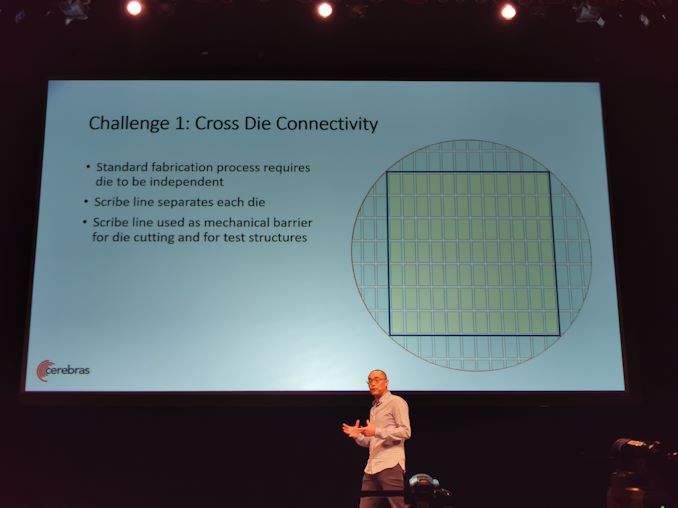

9:05 EDT – Behöver anslutning mellan tvärsatser, utbyte, termisk expansion

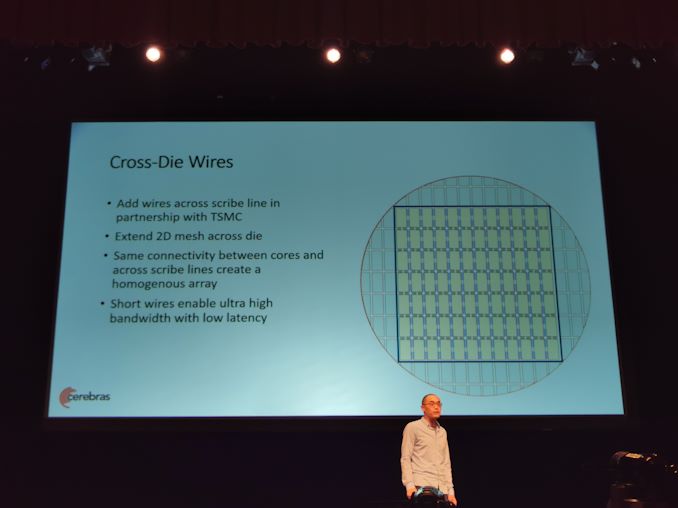

21:06 EDT – Skribentradet skiljer tärningarna. Gör kablar över skrivarlinjen

09:07 EDT – Expandera 2D-nätduk i alla formar

09:07 EDT – Samma anslutning mellan kärnor och mellan matriser

09:07 EDT – Effektivare än off-chip

09:07 EDT – BW är fullt på död nivå

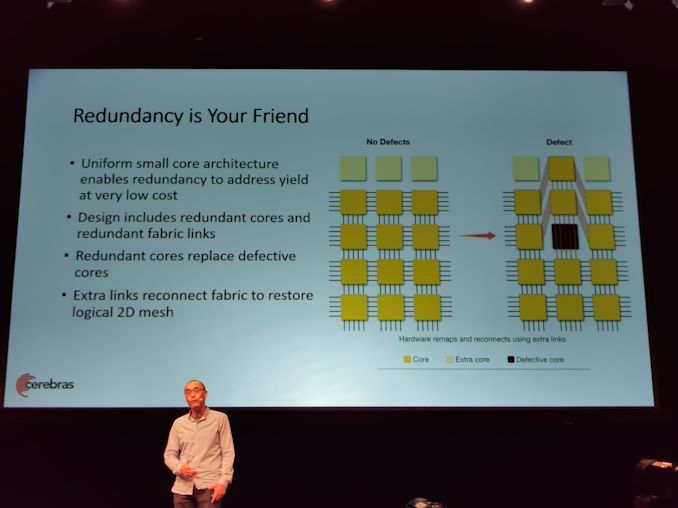

21:08 EDT – Redundans hjälper producera

21:08 EDT – Redundanta kärnor och redundanta tyglänkar

21:08 EDT – Anslut tyget igen med en länk

21:08 EDT – Höga avkastning

21:09 EDT – Transparent till programvara

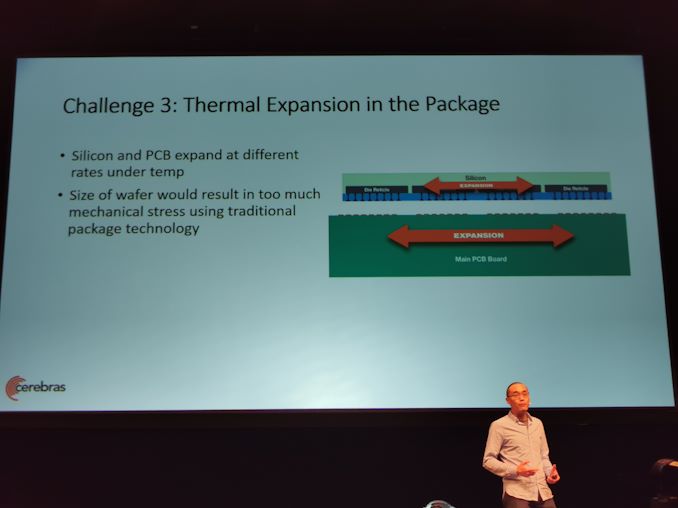

21:09 EDT – termisk expansion

21:09 EDT – Normal teknik, för mycket mekaniskt tryck genom termisk expansion

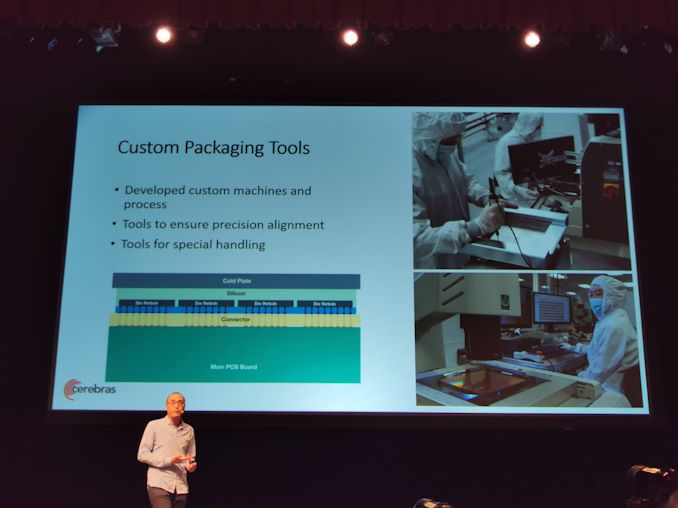

21:09 EDT – Specialanslutning utvecklad

21:09 EDT – Kontakten absorberar variationer i termisk expansion

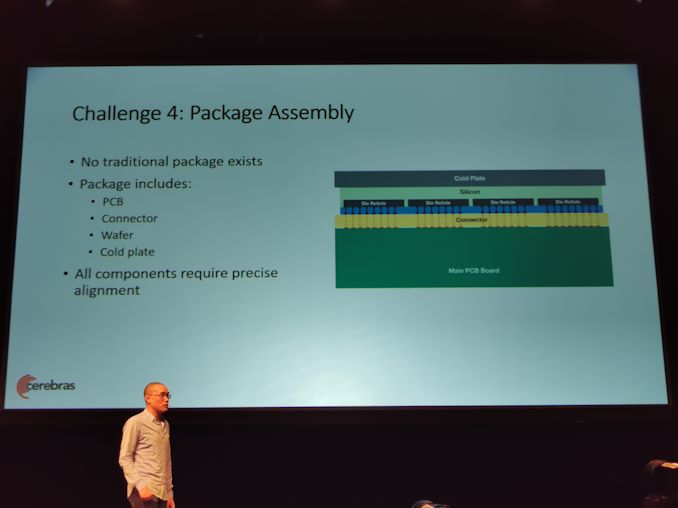

9:10 EDT – Alla komponenter måste hållas med rätt nivellering – speciell förpackningsutrustning

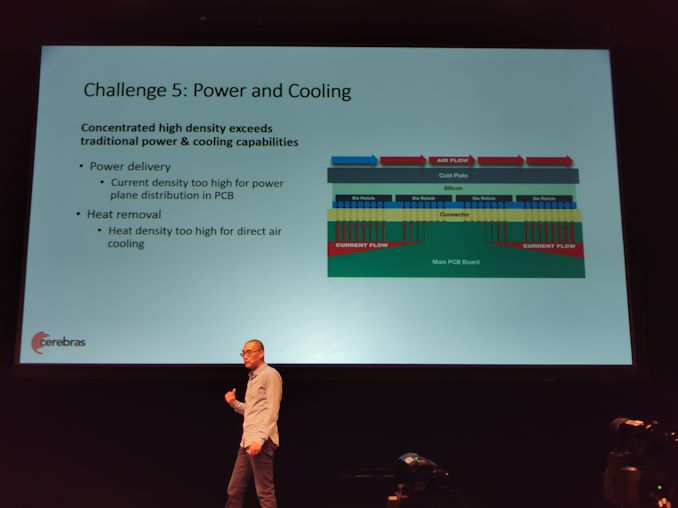

9:10 EDT – Kraft och kylning

9:11 EDT – Elektriska flygplan fungerar inte – inte tillräckligt med koppar på kretskortet för att göra det på det sättet

9:11 EDT – Värmetätheten är för hög för direkt luftkylning

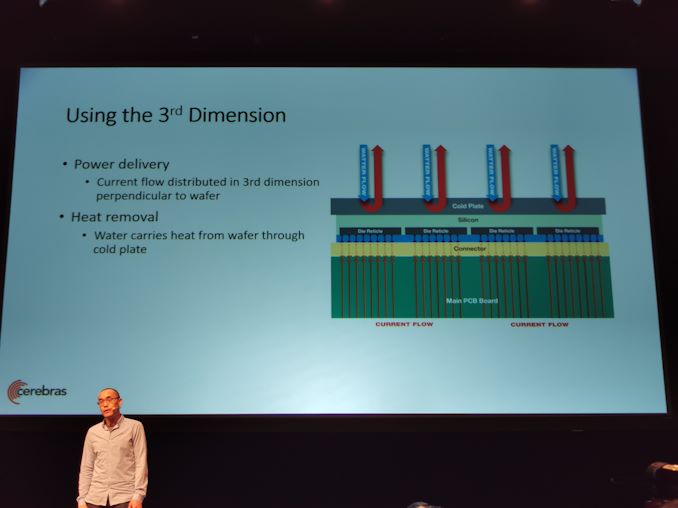

21:12 EDT – Ta med den aktuella vinkelrätten till skivan. Vatten kyls också vinkelrätt

9:14 EDT – Frågestund

9:14 EDT – Q och A

9:14 EDT – Har använts? Ja

9:15 EDT – Kan du skapa en rund chip? Mer bekväm ruta

9:15 EDT – Resultat? Den mogna processen är ganska bra och enhetlig

21:16 EDT – Är priset billigare än ett hus? Allt amorteras över hela skivan

21:17 EDT – Rutinprocessor för hushållning? De kan alla göra det

21:17 EDT – Är det helt synkront? Inte

9,20 EDT – Klockfrekvens? Ej avslöjad

9,20 EDT – Vi är klara. Nästa är Habana