Video mereproduksi operasi Apple Kacamata dan kami menjelaskan cara kerjanya

Pada 10 September, di samping rilis versi Golden Master iOS 13 dan beta 3 dari 13.1, a Apple Sesuatu "terpeleset". Biasanya ketika versi ini dirilis, mereka biasanya "bersih" dari perpustakaan yang terkait dengan produk itu Apple belum diumumkan, terutama karena lebih normal bagi media untuk memiliki akses ke pengembang yang dapat, dengan rekayasa terbalik, mencari sesuatu yang "tidak boleh ada."

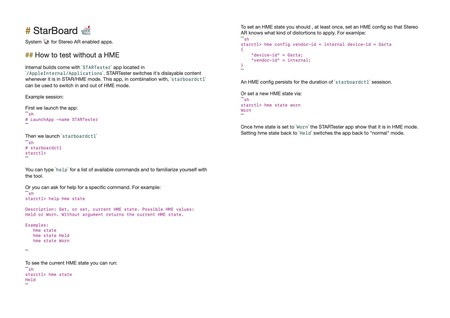

Pada kesempatan ini, "pemecatan" ini, menyebabkan pengembang terkenal Steven Troughton-Smith, menemukan file README dari mereka yang menemani toko buku mana pun untuk mendapatkan informasi. Ini berisi instruksi terperinci tentang cara menguji pustaka StarBoard (yang saat ini tidak ada secara publik untuk perangkat apa pun).

Dalam instruksi ini kita dapat melihat perintah yang akan dieksekusi dan cara mengakses tes perangkat lunak tanpa memiliki apa yang disebut "HME". perangkat fisik lensa augmented reality masa depan Apple. Ini menjelaskan bahwa perangkat ini memiliki dua mode: mode "jeda" atau "ditahan" dan mode "usang" yang akan menjadi sesuatu seperti "berpakaian." Mode ini akan dirancang untuk menguji aplikasi dalam mode ganda.

Sebagai seorang pengembang, saya melihat nama-nama fungsi dan parameter yang menerima mode ini dan bagaimana mereka bekerja dengan tampilan yang memberikan fungsionalitas ke adegan aplikasi augmented reality dan kesimpulan saya adalah bahwa aplikasi augmented reality akan berjalan di iPhone seperti halnya Apple Watch Sekarang dan aplikasinya. Artinya, lensa augmented reality tidak akan menjadi perangkat independen dan akan memiliki semua operasi mereka di telepon. Jadi lensa akan bertindak sebagai layar iPhone kedua yang dapat diaktifkan sesuka hati.

Dalam file informasi perangkat yang didukung iPhone baru dengan prosesor A13 (11 dan 11 Pro) muncul, serta iPhone XS, XR dan XS Max, tetapi tidak untuk generasi sebelumnya. Ini masuk akal bahwa banyak fitur baru dari perpustakaan augmented reality ARKit 3.0 di iOS 13 terbatas pada perangkat dengan prosesor A12. Diantaranya yang paling mencolok seperti oklusi orang yang memungkinkan orang untuk dideteksi di depan objek augmented reality dan mensimulasikan bahwa mereka ada di depan sehingga mereka tidak tertarik di mana orang itu berada. Juga pilihan lain seperti penggunaan simultan kamera depan dan belakang atau penangkapan gerakan orang.

Ketika kita memakai lensa, aplikasi AR akan berjalan di atasnya jika kita memiliki perangkat terkunci dan kita bertanya Siri (atau kita mulai di meja atau peluncur aplikasi di AR). Meskipun seluruh proses akan dilakukan di ponsel. Namun, semua aplikasi juga dapat berjalan di ponsel dan kami dapat meneruskan tampilan mereka ke lensa atau layar ponsel sesuai keinginan, seperti yang akan kami lakukan dengan fungsi Sidecar Mac yang mengirim monitor kedua ke iPad secara langsung. Jika tidak ada aplikasi yang berjalan, lensa akan berada dalam mode "Dimiliki" (seolah-olah dijeda) sehingga mereka tidak akan mengkonsumsi apa pun. Seolah-olah kita membawa arloji di tangan saya dengan layar mati karena kita tidak melihatnya.

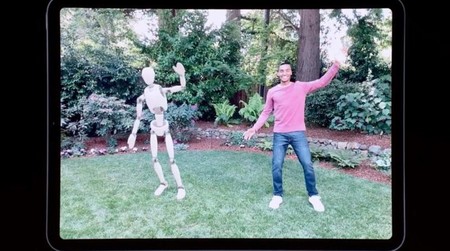

Memanfaatkan teknologi baru deteksi gerak ini dalam augmented reality atau oklusi orang, pengalaman dengan lensa ini akan jauh lebih nyata dan bahkan akan memungkinkan orang yang kita lihat berinteraksi dengan objek dalam realitas virtual tersebut. Juga, seperti yang bisa dilakukan sekarang, kita bisa berbagi pengalaman dan beberapa lensa melihat pengalaman yang sama dan berinteraksi dengannya. Jadi (untuk memberikan contoh) permainan melempar bola raksasa dari satu ke yang lain, itu akan lebih dari mungkin secara teknis dengan alat yang dimiliki pengembang saat ini untuk bekerja.

Mode debug

Apple merenungkan kemungkinan bahwa pengembang aplikasi sendiri tidak memiliki perangkat fisik untuk menguji perkembangan mereka, jadi telah membuat mode "disimulasikan" melalui perangkat atau bahkan dengan Mac dalam mode simulator iOS. Mode yang sekarang, seperti yang telah kita lihat melalui tweet di bawah garis-garis ini, telah berhasil dijalankan dalam mode uji.

@stroughtonsmith Berhasil masuk ke mode uji kacamata apel (alias mode StarTester) dalam 13.1 beta 3 pada iPhone X, tetapi pandangan mata kanan dalam glitchy. (Konten adegan berasal dari uji lampu area saya, bukan dari StarBoard) pic.twitter.com/71chJTBJaA

– xSnow (@__ int32) 20 September 2019

Apa yang kita lihat adalah visi stereoskopik, tempat kami bergerak di atas lingkungan 3D yang lengkap tanpa melihat kenyataan di balik perangkat karena itu berjalan pada Mac. Ini adalah cara yang sama kita dapat mencoba aplikasi augmented reality hari ini dengan simulator iOS di mana bagian yang akan diambil dari kamera berwarna hitam. Dengan cara ini kita dapat mensimulasikan gerakan dan membuktikan bahwa lingkungan bekerja dengan benar bahkan jika kita tidak melihat integrasinya dengan lingkungan.

Jika kita tidak memiliki lensa, tetapi kita dapat menggunakan ponsel, maka akan memasuki mode yang mirip dengan kasus Google Daydream, di mana kami akan meletakkan ponsel di depan mata dan kamera yang sama akan melakukan sisanya. Dengan cara ini, pengembang dapat mencoba dan mengerjakan aplikasi sebelum lensa diluncurkan, sesuatu yang berhenti Apple itu kuncinya jika Anda mau memiliki aplikasi untuk lensa ini pada hari peluncuran.

Kapan Apple dirilis pertama Apple Watch, mempresentasikannya 7 bulan sebelum diluncurkan dan memberikan alat kepada pengembang untuk membuat aplikasi. Cara mengujinya adalah dengan add-on yang memiliki simulator iOS yang merupakan jam itu sendiri di Mac. mode uji akan menjadi dua ini.

Pengembang telah membagikan kode yang mengaktifkan mode ini sehingga siapa pun dapat mencobanya. Dia bahkan berhasil bekerja pada iPhone X dengan chip A11, tetapi ketika dia mengatakan, Ini memiliki kegagalan di salah satu mata (seperti yang terlihat di video) dan tidak berfungsi dengan baik. Dalam XS yang dia coba kemudian dia mengkonfirmasi bahwa semuanya berjalan dengan sempurna.

Seperti yang diekstrak dari beberapa file konfigurasi, Apple Saya akan bekerja dengan 3 prototipe: Franc, Luck dan Garta. Masing-masing dari mereka akan memiliki tingkat bidang pandang yang berbeda, meskipun kami menganggap bahwa perangkat final yang beredar di pasaran hanya akan menjadi salah satunya. Yang pertama memiliki 61 derajat FOV (bidang penglihatan), 58 kedua dan 68 terakhir. Kita harus ingat bahwa lensa augmented reality tidak mencakup seluruh bidang penglihatan mata, hanya area spesifik yang merupakan tempat kita melihat kenyataan diproyeksikan. .

Oktober 2019, Maret 2020 atau September 2020

Ini adalah tanggal yang ditangani: Oktober 2019 di yang baru keynote itu bisa menjadi momen ketika prototipe disajikan dan alat-alat ini dirilis untuk umum yang telah kami komentari hari ini, sehingga pengembang dapat bekerja pada aplikasi ketika lensa diluncurkan. Peluncuran itu bisa pada bulan Maret tahun depan atau bahkan pada bulan September dengan iPhone generasi berikutnya (iPhone 12?).

Ada banyak yang tidak diketahui di sekitar perangkat baru ini, tidak diragukan lagi, tetapi kita dapat berpikir seperti itu Apple Watch Butuh bertahun-tahun untuk matang sebagai perangkat dan menjangkau mayoritas orang, mendapatkan ekosistem aplikasi dan layanan yang matang untuk itu, lensa ini akan menjadi langkah pertama dan ke arah yang benar oleh Apple, untuk menghasilkan produk dan menempatkannya di pasar seperti yang telah dilakukan pada kesempatan sebelumnya. Mari kita tunggu untuk melihat apa lagi yang mereka tawarkan kepada kita.