Nếu bạn không muốn chia sẻ thông tin hoặc dữ liệu của mình với OpenAI hoặc các nhà cung cấp AI tương tự khác. Bạn có thể quan tâm đến hướng dẫn này, cung cấp thông tin tổng quan về cách bạn có thể sử dụng API LocalGPT để tạo trợ lý AI cá nhân của riêng mình.

LocalGPT là một công cụ mạnh mẽ dành cho bất kỳ ai muốn chạy mô hình giống GPT cục bộ, cho phép bảo mật, tùy chỉnh và sử dụng ngoại tuyến. Nó cung cấp cách đặt câu hỏi cho các tài liệu hoặc bộ dữ liệu cụ thể, tìm câu trả lời từ các tài liệu đó và thực hiện các hành động này mà không cần dựa vào kết nối Internet hoặc máy chủ bên ngoài và có sẵn thông qua Github

LocalGPT là gì và nó hoạt động như thế nào

- cảm hứng: Nó được lấy cảm hứng từ một dự án khác có tên là “privateGPT”. Nó dường như đi theo một khái niệm tương tự nhưng có những tính năng độc đáo.

- Thay thế mẫu: LocalGPT thay thế mô hình GPT4ALL bằng mô hình Vicuna-7B và sử dụng InstructorEmbeddings thay vì LlamaEmbeddings.

- Thực thi riêng tư và cục bộ: Dự án được thiết kế để chạy hoàn toàn trên máy cục bộ của người dùng, đảm bảo quyền riêng tư vì không có dữ liệu nào rời khỏi môi trường thực thi. Điều này cho phép nhập tài liệu và đặt câu hỏi mà không cần kết nối internet.

- Nhập tài liệu: Người dùng có thể nhập nhiều loại tài liệu khác nhau (.txt, .pdf, .csv, .xlsx) vào kho lưu trữ vectơ cục bộ. Sau đó, các tài liệu này được sử dụng để tạo phần nhúng và cung cấp ngữ cảnh cho các phản hồi của mô hình.

- Trả lời câu hỏi: Người dùng có thể đặt câu hỏi cho tài liệu của họ và mô hình sẽ phản hồi bằng cách sử dụng dữ liệu cục bộ đã được nhập. Các phản hồi được tạo bởi Mô hình ngôn ngữ địa phương (LLM), như Vicuna-7B.

- Được xây dựng với nhiều công nghệ khác nhau: LocalGPT được xây dựng bằng các công cụ và công nghệ như LangChain, Vicuna-7B, InstructorEmbeddings và Chroma vector store.

- Môi trường và khả năng tương thích: Nó cung cấp hướng dẫn thiết lập môi trường thông qua Conda hoặc Docker và hỗ trợ chạy trên cả CPU và GPU. Các hướng dẫn cụ thể cũng được cung cấp để tương thích với các hệ thống khác nhau như GPU Nvidia, Apple Silicon (M1/M2), v.v.

- Hỗ trợ giao diện người dùng và API: Dự án bao gồm khả năng chạy giao diện người dùng và API cục bộ để tương tác với mô hình.

- Uyển chuyển: Nó cung cấp các tùy chọn để thay đổi mô hình LLM cơ bản và cung cấp hướng dẫn về cách chọn các mô hình khác nhau có sẵn từ HuggingFace.

- Yêu cầu hệ thống: LocalGPT yêu cầu Python 3.10 trở lên và có thể cần trình biên dịch C++, tùy thuộc vào hệ thống.

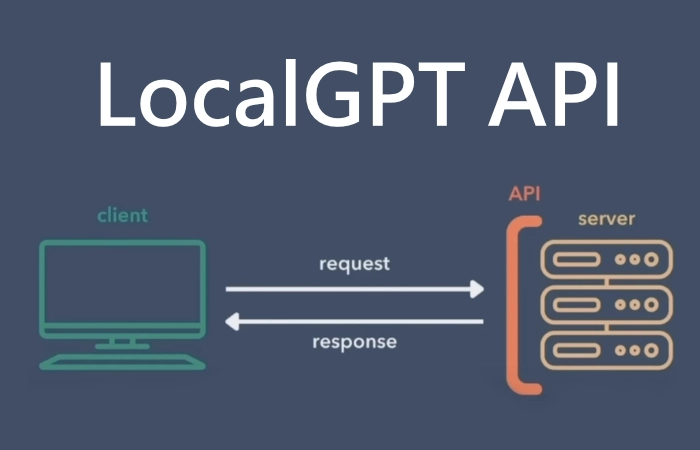

LocalGPT không chỉ liên quan đến quyền riêng tư; nó cũng là về khả năng tiếp cận. Bằng cách đặt phiên bản LocalGPT trên đám mây trên một máy mạnh mẽ, các lệnh gọi API có thể được thực hiện để xây dựng ứng dụng. Phương pháp này cho phép khách hàng chạy các ứng dụng mà không cần GPU mạnh mẽ, cung cấp khả năng mở rộng trên nhiều máy tính hoặc máy.

Xây dựng trợ lý AI cá nhân của riêng bạn

Các bài viết khác có thể bạn quan tâm về trí tuệ nhân tạo:

Quá trình này bao gồm một loạt các bước, bao gồm sao chép kho lưu trữ, tạo môi trường ảo, cài đặt các gói cần thiết, xác định mô hình trong tệp constant.py và chạy API và GUI. Nó được thiết kế thân thiện với người dùng và có sẵn hướng dẫn từng bước thông qua video hướng dẫn được tạo bởi Kỹ thuật nhanh chóngđảm bảo rằng ngay cả những người mới làm quen với AI cũng có thể tận dụng được công nghệ này.

Ứng dụng LocalGPT

LocalGPT không chỉ là một công cụ độc lập; đó là một nền tảng có thể được sử dụng để xây dựng các ứng dụng. API chạy trên địa chỉ localhost có Cổng 5110 và có thể chạy một giao diện người dùng riêng để tương tác với API LocalGPT. Giao diện người dùng này cho phép người dùng tải tài liệu lên, thêm chúng vào cơ sở kiến thức và đặt câu hỏi về những tài liệu đó, minh họa cách sử dụng API LocalGPT để tạo các ứng dụng phức tạp.

Hơn nữa, API LocalGPT có thể được phân phát trên đám mây, cho phép giao diện người dùng cục bộ thực hiện lệnh gọi tới API. Điều này mở ra những khả năng vô tận để phát triển các giải pháp dựa trên AI riêng tư, an toàn và có thể mở rộng.

Một trong những điểm mạnh của LocalGPT là tính linh hoạt của nó. Định nghĩa mô hình đã được chuyển sang constant.py, cho phép người dùng xác định mô hình họ muốn sử dụng trong tệp này. Hướng dẫn sử dụng mã có trong video hướng dẫn, giải thích cách hoạt động của mã, bao gồm cách lưu trữ tệp, cách tạo DB vectơ và cách kiểm soát các chức năng API. Mức độ hiểu biết sâu sắc và tùy chỉnh này đặt quyền lực vào tay người dùng, cho phép các giải pháp được điều chỉnh phù hợp với nhu cầu cụ thể.

trí tuệ nhân tạo

LocalGPT thể hiện một tiến bộ đáng kể trong lĩnh vực AI, cung cấp con đường dẫn đến các tương tác AI riêng tư, bản địa hóa mà không cần phần cứng chuyên dụng. Video hướng dẫn cung cấp hướng dẫn toàn diện về cách thiết lập API GPT cục bộ trên hệ thống của bạn và chạy một ứng dụng mẫu được xây dựng trên đó, giúp nhiều người dùng có thể truy cập được.

Cho dù bạn là một cá nhân muốn khám phá AI, một doanh nghiệp đang tìm cách tích hợp AI mà không ảnh hưởng đến quyền riêng tư hay một nhà phát triển muốn xây dựng các ứng dụng sáng tạo, LocalGPT đều cung cấp một giải pháp đầy hứa hẹn. Sự kết hợp giữa quyền riêng tư, tính linh hoạt và tính dễ sử dụng của nó sẽ mở đường cho một kỷ nguyên mới về hỗ trợ AI được cá nhân hóa, tất cả đều nằm trong giới hạn của môi trường cục bộ hoặc phiên bản đám mây của bạn. Tương lai của AI là ở đây và nó bắt đầu với LocalGPT.

Tuyên bố từ chối trách nhiệm: Một số bài viết của chúng tôi bao gồm các liên kết liên kết. Nếu bạn mua thứ gì đó thông qua một trong những liên kết này, APS Blog có thể kiếm được hoa hồng liên kết. Tìm hiểu về Chính sách tiết lộ của chúng tôi.