Tại sao nó quan trọng: Groq là công ty khởi nghiệp thứ một trăm trong việc tạo ra một thẻ tăng tốc AI, thứ hai để đưa ra thị trường và là sản phẩm đầu tiên có sản phẩm đạt được 1 hoạt động bốn triệu mỗi ngưỡng thứ hai. Điều đó làm tăng gấp bốn lần hiệu năng của thẻ mạnh nhất Nvidia.

Bộ xử lý phát trực tuyến Groq Tensor (TSP) cần 300W mỗi lõi, vì vậy, may mắn thay, nó chỉ có một. Thậm chí may mắn hơn, Groq đã biến điều đó từ một bất lợi thành sức mạnh lớn nhất của TSP.

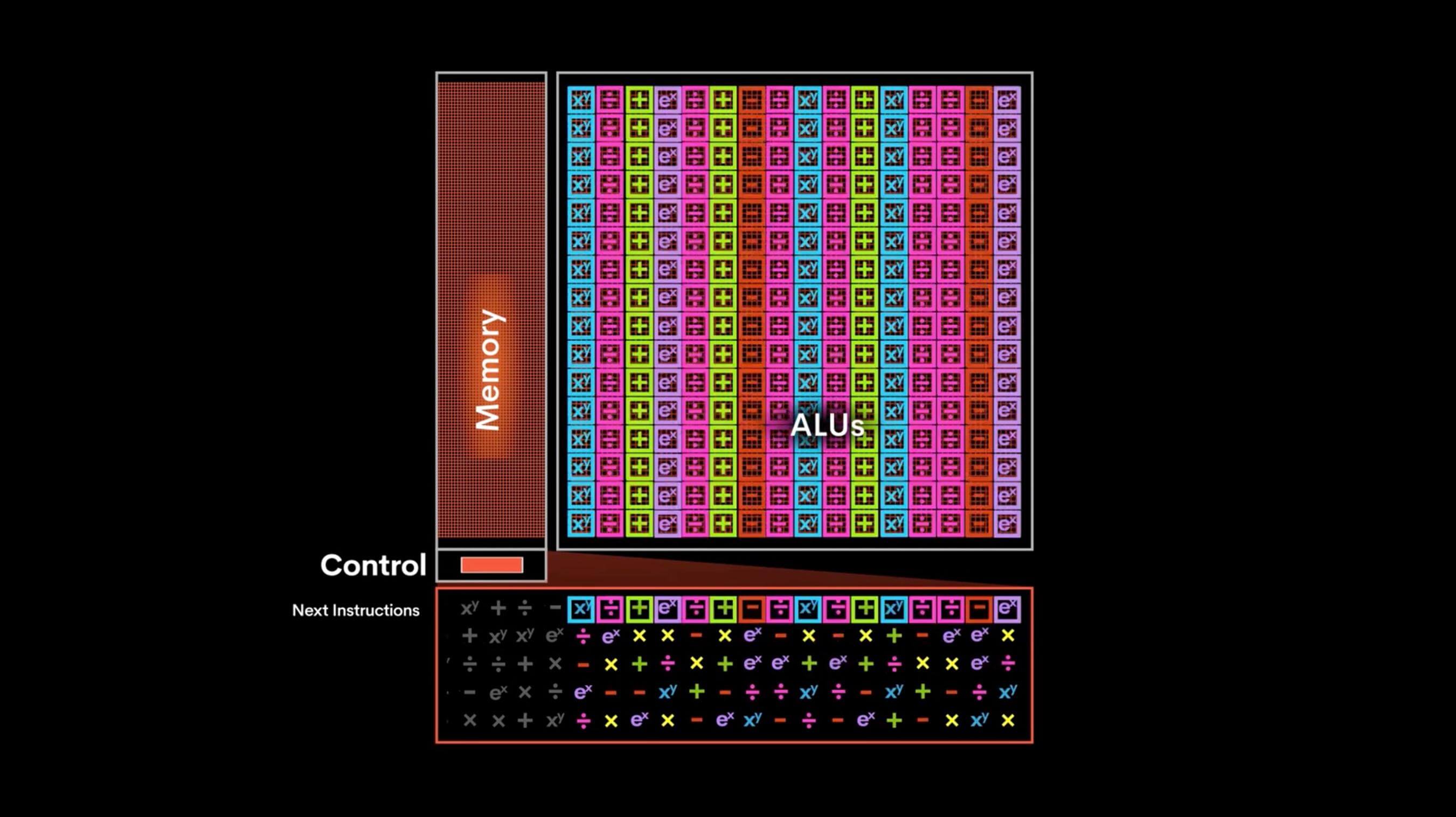

Có lẽ bạn nên ném mọi thứ bạn biết về GPU hoặc xử lý AI ra khỏi cửa sổ, vì TSP chỉ đơn giản là kỳ dị. Nó có một miếng silicon khổng lồ gần như không có gì ngoài các đơn vị xử lý Vector và Matrix và bộ đệm, vì vậy không có bộ điều khiển hay phụ trợ nào. Trình biên dịch có kiểm soát trực tiếp.

TSP được chia thành 20 siêu phẳng. Các siêu phẳng được xây dựng từ, theo thứ tự từ trái sang phải: Đơn vị ma trận (320 MAC), Switch Đơn vị, Đơn vị bộ nhớ (5.5 MB), Đơn vị vectơ (16 ALU), Đơn vị bộ nhớ (5.5 MB), Switch Đơn vị, Đơn vị ma trận (320 MAC). Bạn có thể nhận thấy rằng các thành phần được nhân đôi xung quanh Đơn vị Vector, điều này phân chia siêu nhân thành hai bán cầu có thể hoạt động gần như độc lập.

Luồng lệnh (chỉ có một) được đưa vào mọi thành phần của superlane 0, với 6 hướng dẫn cho các đơn vị ma trận, 14 cho Switch Đơn vị, 44 cho Đơn vị bộ nhớ và 16 cho Đơn vị Vector. Mỗi chu kỳ đồng hồ, các đơn vị thực hiện các hoạt động của mình và di chuyển đoạn dữ liệu đến nơi mà nó đi tiếp theo trong siêu năng lực. Mỗi thành phần có thể gửi và nhận 512B từ hàng xóm bên cạnh.

Khi các hoạt động Superlane sắp hoàn thành, nó sẽ chuyển mọi thứ xuống tới siêu nhân tiếp theo và nhận bất cứ thứ gì siêu nhân ở trên (hoặc bộ điều khiển lệnh) có. Các hướng dẫn luôn được truyền xuống theo chiều dọc giữa các siêu phẳng, trong khi dữ liệu chỉ truyền theo chiều ngang trong một siêu lớp.

| Groq TSP | Nvidia Tesla V100 | Nvidia Tesla T4 | |

| Lõi | 1 | 5120 | 2560 |

| Tần suất tối đa | 1250 MHz | 1530 MHz | 1590 MHz |

| TFLOPS FP16 | 205 TFLOPS | 125 TFLOPS | 65 TFLOPS |

| NHIỆM VỤ INT8 | 1000 TOPS | 250 TOPS | 130 TOPS |

| Chip Cache (L1) | 220 MB | 10 MB | 2.6 MB |

| Bộ nhớ bảng | Không có | 32 GB HBM2 | 16 GB GDDR6 |

| Bảng điện (TDP) | 300W | 300W | 70W |

| Quá trình | 14nm | 12nm | 12nm |

| Khu vực chết | 725 mm² | 815 mm² | 545 mm² |

Tất cả những gì làm cho một bộ xử lý cực kỳ tốt trong đào tạo và suy luận mạng thần kinh, và không có khả năng của bất cứ thứ gì khác. Để đặt một số điểm chuẩn cho nó, trong ResNet-50, nó có thể thực hiện 20.400 suy luận mỗi giây (I / S) ở bất kỳ kích thước lô nào, với độ trễ suy luận là 00,05 ms.

Nvidia từ Tesla V100 có thể thực hiện 7, 907 I / S ở cỡ lô 128 hoặc 1, 156 I / S với kích thước lô là một (kích thước lô thường phát sinh ở mức thấp này, nhưng nó thể hiện tính linh hoạt của TSP nhiệt). Độ trễ của nó ở lô 128 là 16 ms và 00,87 ms ở đợt một. Rõ ràng, TSP vượt trội so với thẻ tương đương nhất của Nvidia, trong khối lượng công việc này.

Một trong những điểm mạnh của TSP là nó có rất nhiều bộ đệm L1, nhưng nó cũng không có gì khác. Nếu một mạng lưới thần kinh mở rộng vượt quá khối lượng đó hoặc nếu nó đang xử lý các đầu vào rất lớn, nó sẽ bị ảnh hưởng nghiêm trọng. Thẻ NvidiaTHER có bộ nhớ gigabyte có thể xử lý tình huống đó.

Điều này tổng hợp TSP thực sự tốt. Trong các khối lượng công việc cụ thể, nó có thể mạnh hơn gấp đôi so với Tesla V100, nhưng nếu khối lượng công việc của bạn thay đổi hoặc nếu trời cấm bạn muốn làm một cái gì đó với độ chính xác hơn một nửa, bạn có thể đập. TSP chắc chắn có một tương lai trong các lĩnh vực như xe tự lái, nơi khối lượng đầu vào có thể dự đoán được và mạng lưới thần kinh có thể được đảm bảo phù hợp. Trong trường hợp này độ trễ ngoạn mục của nó, tốt hơn 320 lần so với Nvidia, có nghĩa là chiếc xe có thể đáp ứng nhanh hơn.

TSP hiện có sẵn để chọn khách hàng làm máy gia tốc trong Đám mây Nimbix.